深度學習與神經形態計算之爭 英特爾高管與AI大牛互懟

英特爾神經形態計算實驗室主任Mike Davies在國際固態電路會議(ISSCC)上將深度學習批判了一番。

Davies說,深度學習跟大多數人印象中的并不一樣,它只是一種優化程序,實際上并不是真正在“學習”。

受到攻擊的重災區,還是深度學習中的反向傳播算法。

他說,反向傳播與大腦無關,而只是在深度學習計算機程序中用來優化人工神經元響應的一種數學技術。

自然的反向傳播例子,并不存在。

雖然他承認深度學習現在非常有效,但他也堅定地強調里,大腦才是真正智能計算的范例。

Davies死死抓住不放的“不像大腦”這個問題,也正是深度學習教父Hinton一直重視的。

不過對于這次批判本身,美國媒體ZDNet認為,他主要的攻擊目標其實是Yann LeCun。

深度學習vs.神經形態計算之爭

為何攻擊LeCun?

就在周一,這位AI大牛在同一個學術會議上發言時,順便批判了Davies在搞的神經形態計算。

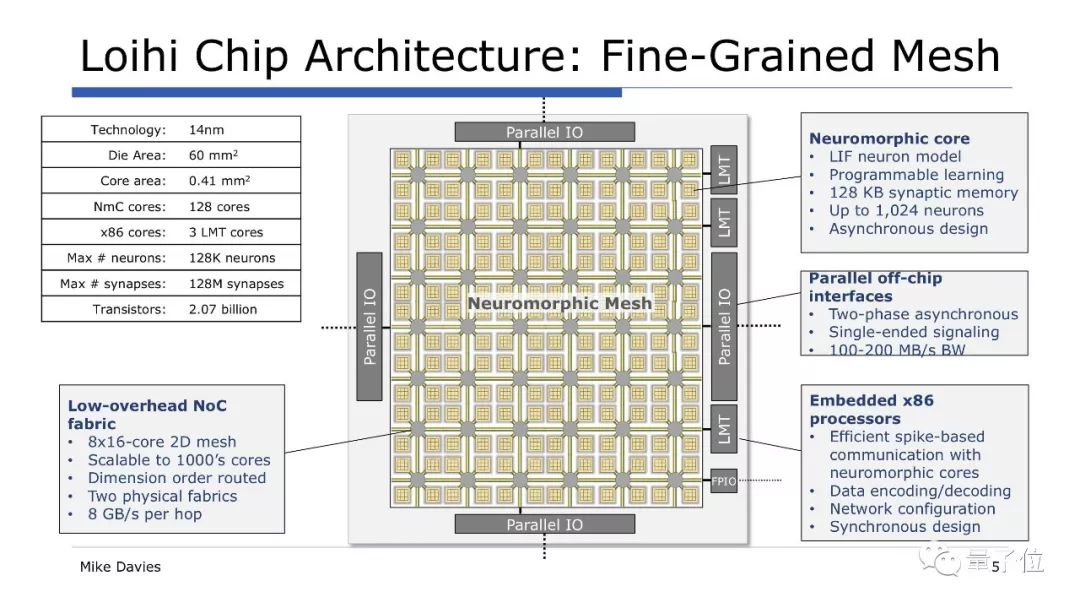

神經形態計算是英特爾布局的一個重要新興方向,在這個領域,他們推出了芯片樣品Loihi。英特爾說,這種芯片可以實現自主學習,而且能耗只有傳統芯片的千分之一。

而Davies就是神經形態計算實驗室的負責人,主管著英特爾在這一領域的探索。他參加ISSCC會議,也是來講Loihi的。

Loihi用了一種名叫尖峰神經元(spiking neurons)的技術,這類神經元只有在輸入樣本后才能被激活。

神經形態計算倡導者們認為,這種方法更好地模擬了大腦的運行機制,比如說信號傳遞的過程就像大腦一樣經濟。

在LeCun看來,神經形態計算領域沒有產生有實際效果的算法,為何要為一種沒用的算法構建芯片?

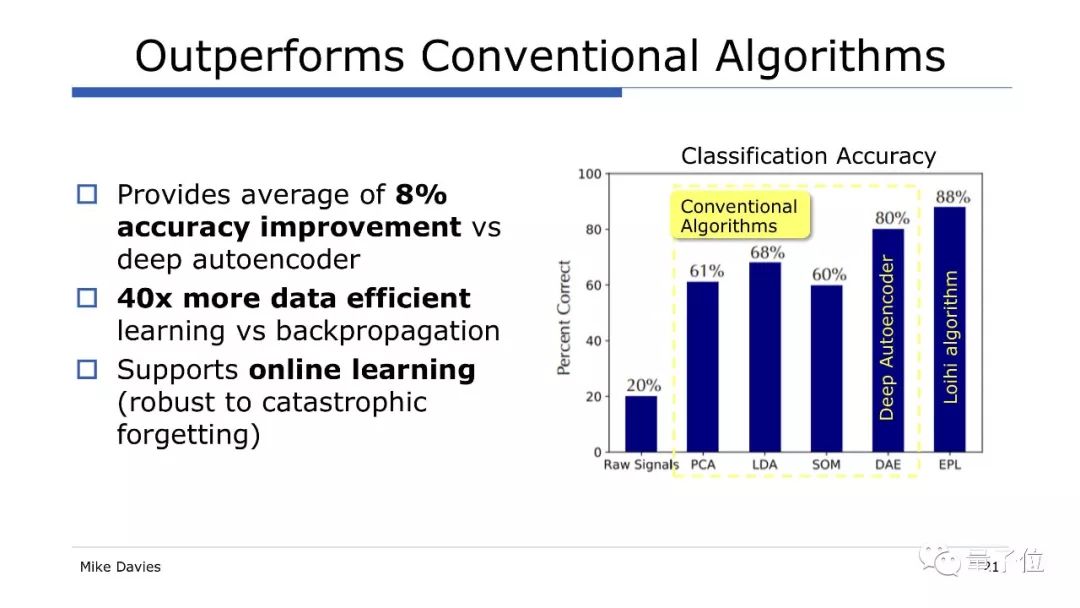

不過Davies直接表達了反對,他說,神經形態計算產生的算法是有效的,LeCun忽視了神經形態計算的優勢。

Davies說:“LeCun反對尖峰神經元,但他卻說我們需要解決硬件中的稀疏性,尖峰神經元就是干這個的啊。”

他說,這太諷刺了。

為了駁斥對尖峰神經元的批評,Davies引用了安大略滑鐵盧一個名叫應用腦科學(Applied Brain Science)的機構的數據,比較了一種語音檢測算法在不同芯片上的表現。

這個算法被要求識別“aloha”這個詞,并且拒絕無意義詞語,這家機構在CPU、GPU和Loihi芯片上運行了這一算法。

這份數據顯示,Loihi在常規處理器上運行常規神經網絡性能最佳,特別是在計算速度方面,并且能源效率更高,不過精確度會低一些。

在另一個例子中,Davies說Loihi執行的基本分類器任務的速度是傳統的基于GPU的深度學習網絡的40倍,準確度提高了8%。

因此,Davies認為Loihi效率高得多,可以運行規模越來越大的網絡,他認為,機器人控制將會是Loihi這類神經形態芯片的殺手級應用。

Davies還從LeCun的批評挑出了他認同的一點:尖峰神經元的硬件非常充足,提供了很多工具來映射有趣的算法。

針對這句話后邊隱含的“但是軟件算法層面不行”,Davies說,他的團隊當前目標就是在算法上取得進展,算法確實拖了這個領域的后腿。

在推特上,也有人隔空參與了這場辯論。

有人認為,神經形態計算就像量子計算一樣處在起步階段,所以沒什么可批判的。

也有人覺得深度學習已經在許多領域內取得了成果,量子計算和神經形態計算還差得遠,雖然技術很尤其,但兩者都沒有被證實,而且都沒有編程模型。

其實,這場LeCun和Davies的爭斗,除了學術方面之外,另外不得不考慮的一點就是Facebook和英特爾的商業競爭。

周一,LeCun表示Facebook內部正在開發AI芯片,一旦Facebook自己的芯片研發成功,那就不需要使用英特爾的芯片了,甚至還會搶走英特爾的客戶。

看完這場隔空口水戰的來龍去脈,我們把目光收回到Davies指責的核心:反向傳播。

訓練深度學習模型離不開它,但對它的質疑也接連不斷。

反向傳播到底行不行?

反向傳播,生于1986,出自David Plaut、Steven Nowlan、Geoffrey Hinton在卡耐基梅隆大學(CMU)時發表的Nature論文:Experiments on Learning by Back Propagation。

△www.cs.toronto.edu/~fritz/absps/bptr.pdf

31年后,這一概念已經隨著深度學習廣泛應用到了各種領域,也遇到了最大的一次危機。

它的的提出者之一、“深度學習之父”Hinton在多倫多舉辦的一場會議上公開提出了質疑。

他說,他對反向傳播“深感懷疑”,甚至想“全部拋掉,重頭再來”。因為,大腦的運作機制并不是這樣的。

“不像大腦”這個問題,Hinton一直非常重視,他曾在MIT的一次講座上說,他相信正是這些不像大腦的東西,導致人工神經網絡的效果不夠好。

在Hinton發出自我質疑之后,反向傳播更成了討論的熱點,甚至被稱為“今日AI的阿喀琉斯之踵”。

不過現在,可能Hinton應該自己的作品稍微滿意一點了。

哈佛大學臨床神經科學學院的兩位科學家在最新一期Cell旗下期刊《認知科學趨勢》(Trends in Cognitive Sciences)上發表綜述,總結了人工神經網絡的反向傳播算法,在大腦中是怎樣體現的。

這篇綜述題為“大腦中誤差反向傳播的理論”(Theories of Error Back-Propagation in the Brain),綜合了近來的一批理論研究,分析幾類生物反向傳播模型。

作者說,這些理論研究“否定了過去30年來普遍接受的教條,即:誤差反向傳播算法太復雜,大腦無法實現”。

根據這些研究,腦神經回路中類似反向傳播的機制,是基于突觸前和突觸后神經元活動的簡單突觸可塑性規則。

論文:https://www.cell.com/trends/cognitive-sciences/fulltext/S1364-6613(19)30012-9